1 月 1 日 至知创新研究院(IQuest Research)发布全新一代开源代码大模型 IQuest-Coder-V1 系列 。当时宣传性能强劲,在自主性软件工程、竞赛编程等关键维度上,成为了当下开源模型 SOTA。当时的介绍在这里:

九坤投资创始团队成立至知创新研究院,发布开源国产代码大模型 IQuest-Coder-V1,声称开源模型 SOTA,只需 40B 就能秒杀部份闭源模型 - 前沿快讯 - LINUX DO

很快有社区用户(@xeophon)发现在 SWE-bench 测试中,官方配置有无,模型输出中错误引用了 未来日期的 Git commit,相当于考试直接看到答案,大概 24% 的内容都受到了影响,此次测试无效。

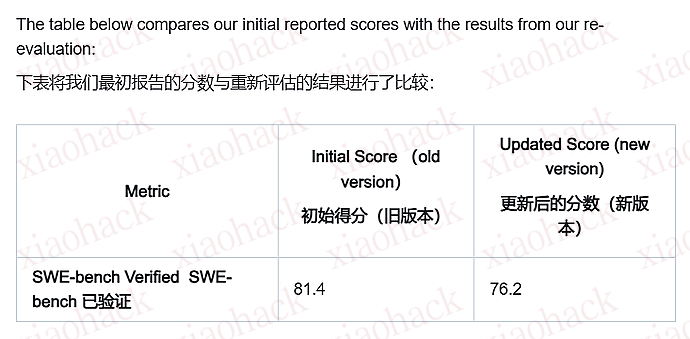

好在官方态度比较积极,修复问题后进行了重新评估:

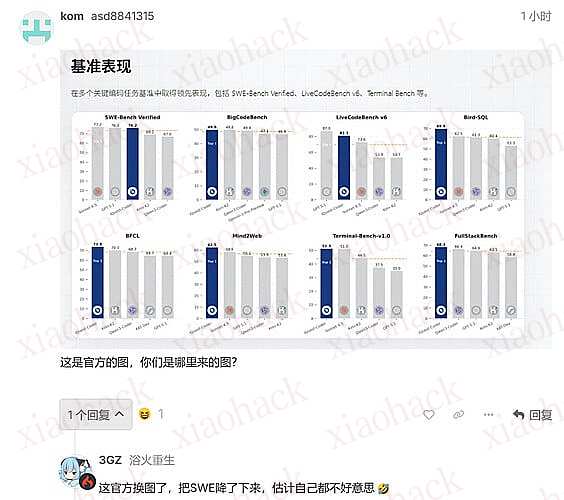

这就是原帖楼下那位发现官方修改评分表现的原因。

之后@HaohaoHenr56041对 Loop-Instruct 版模型做了部署,他的评价是:

・前端设计:与 M2.1 或 GLM4.7 等最新型号相比,差距显著。

・速度:极其缓慢。在两台 A100 80G 处理器上,处理速度仅约为 15 t/s(批处理大小为 1)。

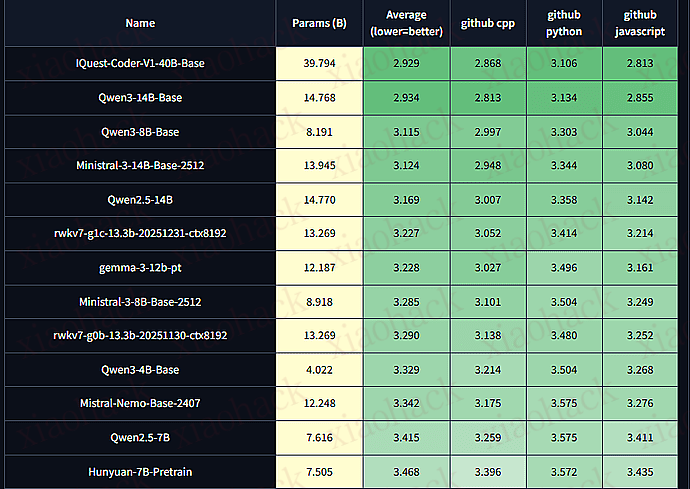

随后 Uncheatable Eval LLM Compression Leaderboard 榜单更新了 base 版模型的评分,可以看到其能力和 Qwen3-14B 相当

(分数越低越好,图源,也是文章资料来源)

需要注意,这里测评的是 base 版模型,而不是得分最高的 loop 版本。

评论区(暂无评论)